Talend Data Fabric – jedyne narzędzie, którego potrzebujesz do integracji danych

Zapraszamy na wyjątkowy webinar, który odkryje przed Tobą tajniki Talend Data Fabric – innowacyjnej platformy do integracji danych i zarządzania ich jakością, która rewolucjonizuje sposób przetwarzania informacji w przedsiębiorstwach.

Dla kogo jest ten webinar?

Webinar jest skierowany do wszystkich, którzy chcą usprawnić procesy biznesowe w swojej organizacji poprzez efektywne zarządzanie danymi. Niezależnie od tego, czy jesteś analitykiem danych, menedżerem IT, czy specjalistą ds. integracji systemów, znajdziesz tu cenne informacje, które pomogą Ci w codziennej pracy.

Wypełnij formularz i uzyskaj nagranie

Dlaczego warto obejrzeć webinar?

- Dowiesz się, co to jest Talend Data Fabric i jakie kluczowe komponenty oraz możliwości oferuje platforma.

- Poznasz konkretne przypadki użycia i korzyści płynące z integracji danych, które pomogą Ci zoptymalizować procesy biznesowe.

- Zapoznasz się z architekturą i kluczowymi modułami Talend Data Fabric, które wspierają zarządzanie danymi w czasie rzeczywistym.

- Zobaczysz na żywo, jak pracować z interfejsem użytkownika Talend, tworzyć i uruchamiać proste przepływy danych oraz monitorować i zarządzać jakością danych.

- Dowiesz się, jak integrować Talend z różnymi źródłami danych, używając złączy i API do wymiany danych oraz jak automatyzować przepływ danych między systemami.

Zarejestruj się i zobacz, jak Talend Data Fabric może przekształcić Twoje podejście do danych, zapewniając szybką i skuteczną integrację z wielu źródeł, a także dokładność i wiarygodność danych.

Transkrypcja materiału wideo

[Paweł Manowiecki]: Witam serdecznie Powoli zbliża się godzina startu. Chęcią bym się dowiedział, może tak w czasie przed startem, kto z Państwa kojarzy rozwiązania talend. Po każdym razie potrenujemy działanie czata, działanie moich słuchawek itd. Czy to jest wielka tajemnica, czy już z tym narzędziem była styczność? Kto miał styczność, niech się chwali.

O, taki żarcik branżowy. Chyba kolega tak coś czuje, kolega Arkady. Styczność. Dlaczego dobry żarcik talendowy? Bo stycz jest to jeden z produktów talenda, taki no-code do przerzucania danych z online’owych źródeł, czyli z SaaS’owych różnych rozwiązań do SaaS’owych hurtowni Więc pozwolisz Arkady że ukradnę ten tekst na jakieś następne wymiana, czy ktoś miał styczność z talendem wcześniej, bardzo dobry tekst.

stycz jest oddzielnym produktem, jest takim produktem dedykowanym do użytkownika, który ma ani grama kodowanie nie zrobić, tak? Jak ktoś z Państwa kojarzy Fivetram, to jest to porównywalne rozwiązanie co do koncepcji działania. I ja pokażę, zasygnalizuję to. Zegar atomowy mówi, że jeszcze minuta tak że zaraz zaczynam.

Pan Marek mówi, że używał kiedyś talenda do ITL i do procesów data quality. Bardzo dobry use case. Pokażę dzisiaj, jak go można używać. Będzie taka część, która może dla tych, co używali, to wywoła wspomnienie jak to było robione w Talendzie jakiś czas temu, ale są też nowe moduły chmurowe i nie tylko chmurowe, może nie to, że chmurowe, a przeglądarkowe, które te procesy mogą wspierać.

Rośnie liczba uczestników, trzynasta wybiła, dzień dobry, moje nazwisko Paweł Manowiecki jestem Data i AI Solution Architektem w Data Wizards i dzisiaj mam przyjemność zaprezentować i porozmawiać o produkcie talend, talend Data Fabric, Fabric taka dygresja lata temu jak usłyszałem Data Fabric to myślałem że chodzi o fabrykę.

No i chodzi o fabrykę, ale to fabrykę tkanin bo to jest tkanina a nie fabryka, ale jedno i drugie metaforycznie mogą pasować do tematu, bo jest to o wytwarzaniu danych i dostępie do nich na tkaninie takiej technologicznej różnych rozwiązań platformy talend, stąd to nazewnictwo od wielu lat funkcjonujące i zainicjowane przez Gartnera, kontynuowane przez Talenda i teraz również podjęte przez konkurencję.

Czy już się zaczęło? Panie Piotrze tak już się zaczęło. Lecę z tematem. Chciałem pokrótce i teraz tutaj kursorek. Żeby. Dane są cennym zasobem. Niektórzy mówią, że jest to olej napędowy naszych czasów i że na tych danych będzie można zarabiać. Jestem w stanie się założyć, że wszystkie wyceny ile tych danych będzie eksplodują w najbliższych latach, bo nie tylko ludzie, nie tylko maszyny, ale też sztuczna inteligencja będzie te dane generowała i trzeba będzie pewnie nawet odsiać to, co jest sztuczne od tego, co jest naturalne.

I te dane przetrwają dłużej więc warto je pielęgnować warto je przytrzymywać w sprytny sposób. O tej rzeczywistości jak się danymi zarządza na bardziej biznesowym poziomie najpierw chcę opowiedzieć o integracji danych, o dbaniu o jakość danych i zarządzanie danymi. Następnie pokazać taki helicopter view, mówiąc po staropolsku z czego składa się platforma talend Data Fabric.

Następnie wejść w świat produktu spróbować bez wtopy pokazać demo wielu ekranów tego rozwiązania. Na koniec otworzymy sesję pytań i odpowiedzi. Postaram się wystartować tę sesję za godzinę czyli żeby wszyscy, którzy planowali godzinę ze mną spędzić, usłyszeli wszystko, a później zapraszam do otwartej sesji pytań i odpowiedzi.

Jak ja to widzę jeśli chodzi o sytuację przy integracji danych? Jakie mamy wyzwania? Jakie wyzwania mają organizacje? Przytłoczenie danymi, w sensie dane się pojawiają i trzeba wymyślać w jaki sposób je konsumować. Jakieś statystyki mówią o tym nawet, że średnio 400 źródeł danych w firmie jest używanych i to czasami jest taki mały paradoks bo jedna konkretna rola, jeden konkretny pracownik firmy myśli o pięciu zbiorach z których korzysta na co dzień, a jak wymnożymy to Jak się wzbijemy wyżej i popatrzymy na całą organizację, to tych źródeł się okazuje być więcej właśnie dlatego, że różne grupy pracują z różnymi zespołami.

Braki specjalistów Z tym wyzwanie jak najbardziej się będzie pogłębiać. Do wszystkiego co technologiczne mamy za mało specjalistów Jasne być może AI pomoże w produktywności tych specjalistów i będą oni mogli więcej robić, ale jednak nadal przetwarzanie danych będzie wymagało tych umiejętności, będzie wymagało umiejętności narzędziowych i coś z tym trzeba zrobić.

Popyt jest duży, a podaż nie zaspokaja tego popytu Skalowanie w działaniu. Bardzo często fajnie jest zrobić coś w postaci pilota proof of concept, szybkiego załadowania danych, ale jeżeli już organizacja się skaluje, dane się skalują, mamy dużo więcej wyzwań, musimy mieć dużo większą perspektywę na to, jak to skalować, jak to ogarnąć.

Sytuacja zwykle nie jest taka prosta, że wszystko jest w chmurze i tylko chmurowe komponenty stanowią część tej zabawy. Czasami jest to hybrydowa zabawa, czy wręcz nawet uciekanie z chmury do on-premu to też się zdarza. Jakie cechy według mnie powinno mieć takie idealne rozwiązania do integracji danych od tej czy innej firmy?

Po pierwsze, musi nadążać za potrzebami biznesowymi, czyli dotrzymać tempa tej ewolucji danych jaką mamy, jak najwięcej konektorów, bo nowe systemy się pojawiają. Abstrakcja technologiczna, w sensie jestem zwolennikiem nie uzależniania się od konkretnego dostawcy, a używania czegoś co bardziej abstrachuje i daje możliwość przerzucenia się technologicznego pod spodem a koncentruje semantycznie bardziej na danych.

Skrócenie i tu chyba jest wstrętny błąd ale to zrzuca na sztuczną inteligencję model GPT-4, chyba bym tak przetłumaczył. Skrócenie czasu na development development i utrzymanie. Im więcej możliwości robienia czegoś bez kodowania, tym więcej użytkowników o mniejszych umiejętnościach. Czy więcej osób z biznesu można zaangażować do tych procesów, ale oczywiście te narzędzia też nie powinny wyłącznie pozostawać na poziomie no code, low code.

Powinny dawać możliwość zejścia głębiej do kodu dla tych, którzy takie umiejętności mają i będą jakieś wyjątkowo specyficzne przypadki chcieli opanować. Rozmaite środowiska, a chcemy mieć doskonałość operacyjną Po pierwsze wielkość coraz większe zbiory, być może jakieś piki w działaniu, piki w przetwarzaniu, nagle jakieś zamknięcie miesiąca generujące dużo więcej zadań, czy jakaś telemetria z urządzenia IoT, która nagle spływa bo się robi ciepło i klimatyzatory padają we wszystkich firmach.

Do tego też trzeba się jakoś dostosować. Z tyłu głowy mam to, że nie zawsze świat jest tak idealny, że wszystko jest w chmurze czy wręcz tak trudne, że wszystko jest on-prem. Trzeba być gotowym na taką zdrową mieszankę. Jeżeli chodzi o integrację danych, to musimy wczytać dane. Możemy je mieć w najróżniejszych aplikacjach, bazach danych, w jakichś starociach legacy typu mainframe, które i tak nadal dowożą ale są i też z nich trzeba pobrać dane.

Czy chociażby brokery. Czy chociażby brokery. Gdzie będziemy nasłuchiwać kolejki, nasłuchiwać w kawce, nasłuchiwać w jakimś serwis basie. Po środku jeżeli mówimy w tym momencie o integracji danych pod kątem analityki, bo tutaj taka mała dygresja, talend nadaje się do integracji danych, gdzie celem jest baza analityczna, ale nadaje się również do międzysystemowej integracji, takiej integratora klasycznej aplikacyjnej gdzie na końcu wcale nie musi być jakaś suma sprzedalczy i ładny wykres, tylko po prostu na przykład sprzęgamy ze sobą jakieś API-e, wymieniamy jakieś pliki, tego typu rzeczy.

Ale dzisiaj mówimy i to jest naszym dużym hobby, o data fabric, o use case o przypadku użycia który dotyczy analityki, gdzie jest business intelligence na końcu, data science, gdzie może ktoś chce policzyć jakiś model, wręcz nawet sztucznej inteligencji, uzbroić dodatkowe dane. To wszystko może się dziać w różnych schematach takich…

W patternach tu mi zabrakło polskiego słowa, w wzorcach wdrożeniowych tego silnika, który przetwarza dane, bo to może być data lake. Wrzucam sobie pliki i one sobie leżą, coś z nim kiedyś zrobię, może uporządkuję, może nie. Data warehouse, hurtownia danych. Wrzucam i już dane są wypielęgnowane, już mają strukturę są sprawdzone, są gotowe na jeden klik w kliku, żeby te dane zassać i coś z nimi robić.

Downstream applications, czyli również podpinanie jakichś systemów, których tych danych potrzebują. System CRM chce umieć jakoś wyliczyć cyferkę dotyczącą lojalności klienta, a to się składa wiele czynników, to się składa cały customer 360 konieczny do ocenie i na końcu wcale nie musi być analityka, może być też na przykład interakcja.

Przy kasie Dostaję jakąś propozycję i nie dostaję jakiejś propozycji rabatu ze względu na to, jak bardzo jestem lubiany przez firmę. Ta integracja danych no to mają Państwo świadomość tych typów formatów danych może być mnóstwo, JSON-y, nie JSON-u, strukturyzowane, bardziej relacyjne bazy danych bazy SQL-owe i dane można dostarczać i tu według potrzeb biznesowych powiedziałbym.

Oczywiście osoby techniczne najbardziej by chciały mieć wszystko w streamingu Ja bardzo bym chciał żeby sensor, który tu wisi za oknem natychmiast pokazywał mi dane w dashboardzie, ale czasami nie jest to ekonomicznie opłacalne albo nie jest to w ogóle wymagane biznesowo, bo jakość powietrza za oknem chce znać tu i teraz, a wyniki biznesowe niekoniecznie musi być to sprzed sekundy bo to jeszcze nic nie mówi.

Także te stylu dostarczania są różne. Leci paczka danych i procesujemy taką paczkę danych i co chwila paczka przyjeżdża od tego kuriera i jest rozpakowywana. Streaming każdy rekord leci, przechodzi przez proces, ląduje w sposób ciągły gdzieś dalej. Albo Change Data Capture, CDC, czyli obserwujemy bazy źródłowe, które mają lub nie mają takich mechanizmów które wspierają to wyłapywanie zmian.

Można albo je skonstruować, albo użyć, podłączyć się do tych mechanizmów mówiących o zmianach po to, żeby wyłącznie przesyłać rekordy które się zmieniają w relacyjnej bazie danych chociażby. I tu w tym obszarze to też mała dygresja, talend jest jedną z możliwości, zostaje mi klika jest jeszcze możliwość Replicate od klika, także też na to zwracam uwagę.

Przy kontakcie możemy doradzić który sposób jest najlepszy najbardziej ekonomiczny. Najbardziej wpasowany w to, jakie potrzeby są w konkretnym przypadku. Transformacja danych. W tej transformacji też wiele się dzieje. Trzeba wyczyścić, trzeba zamapować, trzeba sparsować, trzeba uzdatnić dane, zagregowane, wymodelować.

Można mieć różne wzorce integracji. Albo oldschoolowy, powiedzmy oldschoolowy, ale nadal jednak bardzo szanowany, bo powodujący porządek na końcu od razu czyli transformacja w locie ETL, która na końcu się objawia hurtownią danych w którym mamy dane przygotowane do analityki. Lub też strategią ELT, gdzie dbamy o to, żeby wszystkie źródła danych Składować dane z nich w postaci data lake’a i w tym data lake’u część rzeczy strukturalizować, część rzeczy pozostawiać do dowolnej zabawy analitykom, część rzeczy wręcz w żywy sposób odpytywać z tych źródłowych plików w postaci parquet, delta file, tego typu technologie czy Apache Iceberg.

No i zadania operacyjne, to trzecie. Jeszcze trzeba całą zabawką umieć operować i zarządzać i o tyle o ile, to jest trochę tak jak z różnymi rolami w organizacji, tak. Developer się cieszy czy tam inżynier danych cieszy się jak zrobił tam pipeline, zintegrował dane, to się ładnie łączy, kod wrzuca idzie na weekend, ale na przykład to weekend musi chodzić w sposób zaufany, ktoś musi mieć możliwość monitorowania, czy to się kończy z sukcesem, czy to się kończy o czasie, czy to wyzwala kolejne procesy więc o tym warto nie zapominać.

To jest zwykle robota zrobiona przez mniejszą grupę osób, ale bardzo istotna dla ciągłości. Tego sukcesu i te zadania operacyjne, to jest orkiestracja, co po czym, dlaczego i kiedy, tak. Tu wyślemy żeby się tu przetworzyło, wyślemy, żeby tam się przetworzyło, decydujemy jak bardzo skalować maszynerię pod to, żeby to było przeliczone.

Monitorowanie w postaci wglądu i w metryki wydajnościowe i w szczegóły błędów w produkcji, automatyzacja oczywiście, jest zestaw procesów które dbają o to, żeby to wszystko o czasie i w odpowiedniej sekwencji się wykonało, jak się nie wykona żeby było powtórzone itd. No i jeszcze cykl życia danych, cykl życia w ogóle tego procesu wytwarzania przetwarzania danych.

Takie jest EICD i DataOps pochodna od DevOps, kiedy tą integracją chcemy zarządzać chcemy patrzeć Na wersję tego naszego przetwarzania. Chcemy to testować, chcemy dostarczać w różne miejsca do wykonania. Chcemy też mieć możliwość pełnej obserwowalności naprawiania tego, co jest źle wsadzania z powrotem w tej pętli zwrotnej DevOpsowej problemów z produkcji z powrotem w fiksowanie tego w developmencie i obserwowanie tego, jak również…

W tym miejscu gdzie w procesie jest naprawianie czy programowanie dewelopowanie tego procesu wszystkie wyzwania związane z wielodostępem i współdziałaniem w tym projektowaniu, tak? Czyli to nie zawsze tak jest, że to jest jedna osoba panująca nad konkretnym zbiorem danych. Jest szereg inżynierów zaangażowanych w ten proces, klei to z pewnych klocków, to w całości musi działać.

Niektóre osoby się mogą wymieniać niektóre nie. Współdzielenie kodu, współdzielenie repozytorium, tego typu potrzeby się pojawiają, żeby tym przejrzyście zarządzać, a nie na zasadzie ktoś tam gdzieś w Excelu miał jakiś algorytm i właściwie to nie wiadomo co i jak. Ale jak to mówią Amerykanie, switching gears, przerzucając biegi, integracja danych to tylko jeden krok.

W tym całym cyklu życia danych w organizacji, bo coraz bardziej organizacje dostrzegają, że jakość i zarządzanie tymi danymi stanowi wyzwanie, które czasami jeszcze stoi przed nami, czasami jeszcze nikt nie pochylił się nad tym, dane są przetwarzane, integrowane, ale nie mamy oglądu jakie dane są, gdzie one są, to z czego jest przetwarzane, jakie są wynikowe parametry tego.

I trochę się na tym pochylę, co tutaj należałoby robić, co tutaj można zaplanować w swojej strategii dbania o danych. Po pierwsze jakość możliwość oceniania czynników typu czy dane są dokładne, czy są zupełne, czy są spójne, czy na odpowiedni czas docierają do nas, czy terminowo są przeprocesowane. Czy ich znaczenie jest właściwie opisane, czy znamy je od strony semantycznej, czy są zgodne z biznesowymi słownikami i zarządzanie danymi, czyli mechanizmy w którym możemy wprowadzać polityki, procesy w których zapewnia się, że dane są właściwe, zbierane, przechowywane, używane, udostępniane i wokół tego jest również taka powiedziałbym świadomość adopcji, czy śledzenie adopcji, śledzenie parametrów czy przetwarzamy a ktoś z tego korzysta, czy przetwarzamy sobie i właściwie nie wiadomo po co istnieje ten jeden zbiór, który konsumuje CPU jakiegoś serwera żeby być wyliczonym, a mógłby być przedyskutowany i może zdjęty z agendy Zespołu, który się tym zajmuje.

Jeśli chodzi o elementy jakości danych, to tych elementów jest sporo. Warto, żeby system był świadomy semantyki, żeby mógł odkryć dane, które są w jakiejś bazie, a nie tylko mieć je wypisane kawa na ławę i dopiero wtedy coś móc z tego zrobić. Żeby była możliwość wprowadzania progów jakościowych przy ocenie, żeby można było zobaczyć jakieś statystyki dotyczące tej jakości, żeby pomóc sobie z podnoszeniem tej jakości poprzez magiczne wypełnianie w sensie pomoc systemową modeli takich prostych, machine learning-statystycznych, w których wypełniamy to, czego brakuje wnioskując statystycznie co powinno tam być.

Duplikowanie danych, bo przecież nie wszystko musi przychodzić w tak idealny sposób. Czasami jak czegoś nie kontrolujemy, jak przychodzi to z zewnątrz organizacji to musi być najpierw opanowane. Współpraca społeczności. Trochę nie wiedziałem jak to przetłumaczyć w angielski social curation. Jest organizacja, jest wiele osób zainteresowanych żeby np.

dane główne produktów były wypielęgnowane I powinna być możliwość dbania o jakość tego zbioru pod egidą data stewarda czyli osoby, która albo wręcz data ownera według koncepcji data as a product, ownera, który ten obszar danych będzie dbał w sposób ciągły, żeby zwiększać jego jakość, zwiększać jakość na wyjściu, na wejściu obserwować te statystyki, jak również odpowiadać na takie pytania biznesowe.

Co jest w tej danej kolumnie a jak liczymy marżę pierwszą drugą trzecią i tak dalej. Trust score jest coś takiego opatentowanego zarejestrowanego przez talend. Syntetyczna miara pozwalająca śledzić jak z tą jakością sytuacja się rozwija. Zobaczymy to zresztą w produkcie. Czyli w rozwiązaniu powinien być.

Zostawiłem tutaj celowo te terminy angielskie bo one ładnie wyglądają bo są krótsze, wolałem nie tłumaczyć a są pojęciami rynkowymi, które pewnie Państwo znają. Data profiling, data curation, data validation, observability, obserwowalność tego, co się dzieje, możliwość rozszerzania danych, opieka, data protection w sensie Dbanie o również rzeczy związane na przykład z danymi osobowymi czyli tym klasycznym PII, Personal Identifiable Information, wyłapywaniem gdzie to mamy i czym przypadkiem zbytnio nie krąży po zbiorach danych, no bo co jak GTPR-owe, czyli RODOwe, prawo do zapomnienia nagle wskoczy na listę zadań dla jakiegoś wymagającego klienta który nie chce zobaczyć tych danych w żadnym systemie u nas.

Niezbędne elementy do zarządzania danymi, zarządzanie metadanymi śledzenie przepływu, odkrywanie tych danych, jakieś kraulowanie po bazach danych, żeby to zebrać, klasyfikowanie danych, przypisywanie jak gdyby semantycznej, nawet odgadywanie semantyki pewnych kontaktów Czyli jeżeli podamy… Jak wygląda zwykle NIP, to jak dostanie system kolumna, która ma dane podobne do struktury NIP-u, to powie, że to jest NIP i zacznie porównywać od tego wzorca.

Maskowanie danych i haszowanie, czyli właśnie wprowadzanie tych polityk prywatności danych i wynikające z tego potrzeby w produkcie. Lecę dalej, żeby szybciej dotrzeć. I te dwie rzeczy, te dwa obszary zazębiają się, bo mamy z jednej strony to paliwo, olej napędowy w postaci danych dla firm. Ale chcemy mieć wyniki, chcemy mieć tą konsumpcję, adopcję, chcemy mieć zwinność biznesową, możliwość podejmowania lepszych decyzji, zaufanie do tych danych, przejrzystość, zmniejszenie ryzyk formalno-prawnych, tych compliance’owych, czy zmniejszanie ryzyk technologicznych.

I gdzieś w tym całym procesie dbania o jakość danych, zarządzanie danymi już od strony bardziej miękkiej możemy też myśleć o opiekunach, o stewardach o stewardship ie, czyli nie wiem jak to przetłumaczyć na polski fajnie. To słowo jednak jest w mery krótkie i takie, no nie wiem, sędziowanie, nie za bardzo, ale wprowadzenie ról takich osób, które nie są techniczne, ale dbają o to, żeby jakość tych danych jako produkt była właściwa Czasami jest to funkcja data ownera W organizacji.

Dużo organizacji wprowadzają takie zasady. Sprzedaż ma swojego ownera dla danych sprzedażowych, logistyka dla logistycznych marketing dla marketingowych. I też wszędzie będę powtarzał, że w tym procesie mogą uczestniczyć rozmaite role. To nie jest tylko i wyłącznie ta techniczna osoba, inżyniera od danych.

To mogą być również bardziej miękkie role. To może być data protection officer albo jakiś oficer od security, który też tych narzędzi będzie potrzebował. Do czego chcę przekonać dzisiaj Państwa tu zgromadzonych? Że mamy takie narzędzia dla Was do dyspozycji. W portfolio Clicka pojawił się talend. talend, który jest pełnym, bo zawierającym i komponenty od integracji danych od zarządzania jakością, dbania o jakość, integracji między aplikacyjnej wystawiania API-ów z tymi danymi.

Bardzo elastyczne, bo znowu wracając do Nie tylko w chmurze jest możliwe korzystanie z tych dobroci funkcjonalności. To może być hybrydowe rozwiązanie, to może być wyłącznie on-premise owe, to może być rozwiązany wyłącznie w prywatnej chmurze, gdzieś tam wydzielonej zarządzanej. Można tym narzędziem wypełnić potrzeby tych wymagań formalno-prawnych.

Jest wsparcie 24 na 7 do tego, żeby to działało. Globalne Jest świetna akademia ze świetnymi materiałami do nauki tego wszystkiego. I przechodząc już bardziej w świat technologii, mapa bitwy pod talendem, tak bym to nazwał. Czyli taki slajd w którym najwięcej się dzieje i jak ktoś chce, to niech sobie wydrukuje i na ścianę powiesi.

Eksperci talenda mają, mam taki obraz ale nie, wydrukuję sobie. Ale zabawa polega na tym. Znaczy zabawa. Co chciałem tym obrazkiem przekazać w pigułce? Po pierwsze, że mamy różne role użytkowników Data Citizen to jest taki bardziej technologicznie zorientowany człowiek który coś z danymi robi, ale on nie ma umiejętności inżyniera danych.

Data Steward, ten dbający o te miękkie sprawy jakość Data Analyst to już ten, który potrafi być może nie programując, ale używając danych produktów analitycznych zrobić coś z tymi danymi, wycisnąć je. I inżynier no to wiadomo taki, który już ma te umiejętności, czy to w Pythonie coś umie napisać, czy to potrafi użyć Talenda, czy to potrafi użyć inne komponenty klika.

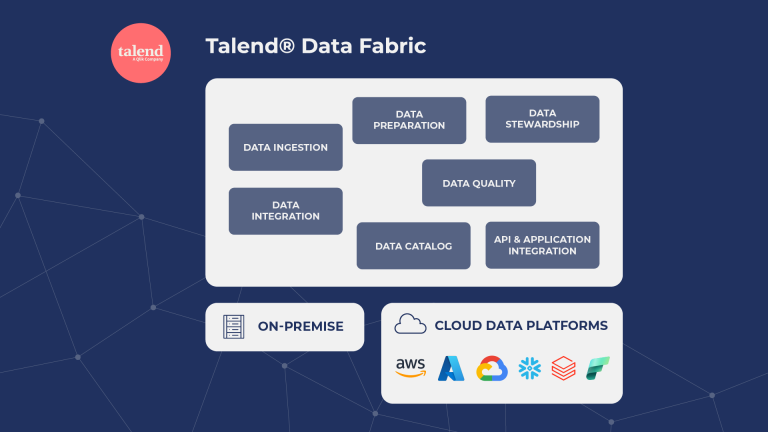

Governance Specialist, Integration Specialist i również użytkownicy biznesowi, o czym jeszcze opowiem. I tutaj te, teraz chcę zwrócić Państwa uwagę na te pudełeczka tutaj w środku To są główne takie kanwy modułów Które można używać od 1 do N. One się przenikają, to znaczy mają wiedzę o sobie i korzystają z tych samych danych talendowych, metadanych talendowych ale talendem można opanować.

Data ingestion, czyli wczytywanie danych. Data integration, czyli integracja. Mieszanie, przeplatanie, czyszczenie, obracanie danych po to, żeby one były zdatne do analityki. Dbanie o jakość danych w postaci takiej, która jest funkcją i dla osoby technicznej, która siedzi i tam bardziej low-code’ów temat opanuje, jak i również osoby biznesowej, która po prostu wie coś a propos np.

produktów i siedzi przed takim ekranem na którym może klasyfikować jakieś produkty do kategoryzacji, która jest słownikiem nakazanym ustalonym wcześniej odgórnie. I to jest ekran nietechniczny nie dla nerda, tylko dla osoby biznesowej, żeby coś z tymi danymi zrobić. Data Stewardship, funkcjonalność, w której na cztery sposoby można zadbać o dane, w postaci takiej również dla biznesu czyli można, to może być student, to może być subject matter, expert, ktoś, kto się zna na danej dziedzinie który może wyznaczać.

Mamy takie dane, jakie dane traktujemy jako właściwe. Funkcjonalności typu uzupełnianie konkretnych braków, poprawianie znowu jakości pokażę to w demo, jak to działa. Data cataloging, perspektywa na to, jakie dane są, skąd one są, co zawierają, jak są opisane, jaką mają jakość i tak dalej, i tak dalej. I te dwa ostatnie boksy trochę nieintuicyjne, bo integracja między aplikacjami i integracja w postaci API.

Tu jeden przykład przytoczę bo jest taki najbardziej, powiedziałbym seksi, Czyli mamy jakiś zbiór danych w katalogu talend Data Fabryk. Możemy jednym kliknięciem wygenerować API, dzięki któremu ktoś będzie mógł te dane konsumować w narzędziu analitycznym albo jakiś partner biznesowy i takie dane mogą być wystawione przez chmurę, przez jakiś ukryty endpoint dla kogoś dostępny po zalogowaniu i tak dalej.

I to wszystko może uprawniona osoba zrobić jednym kliknięciem i taki dataset, czy to jakiś malusieńki typu na przykład słownik produktów, relatywnie malusieńki, ale jak również jakieś dane transakcyjne, pozyskać. I teraz idąc tutaj trochę w dół i po tych napisach na co chcę zwrócić uwagę i uwrażliwić co do możliwości Talenda.

talend sam w sobie danych nie przetwarza, w sensie nie trzyma, tak bym powiedział. Ma je wyłącznie w trakcie procesu Gdzie je przetwarza? Przetwarza tam, gdzie projektant systemu chce, bo cokolwiek wytworzymy w postaci takiej paczki do integracji danych, pokażę to zaraz jakim narzędziem się to robi i co z tego powstaje, taka paczka Może być wrzucona na serwer, który koordynuje całe to środowisko Talenda To się nazywa talend Management Console albo talend Cloud Management Console, bo są dwie wersje, albo on-premisowa, do wyboru do koloru.

I taka paczka zwana inteligentnie artefaktem, taki artefakt do przetwarzania danych, jest wysyłany do takiej czapki w postaci konsoli zarządzania. I ta konsola zarządzania ma podpięte silniki przetwarzania. Te silniki przetwarzania mogą być następujące. Albo takie, które Click talend hostuje. Jest to maszyna która kryje się za jakąś tam niewinną nazwą i całą resztę zabawy robi talend.

To może być własna maszyna, to może być środowisko klastrów, to może być środowisko kontenerów. I takie engine’y w najróżniejszych miejscach organizacji i w najróżniejszych miejscach infrastruktury można umieszczać I w chmurze i w on-premie, tylko w on-premie, w hybrydowym, wszystkie kombinacje dozwolone.

Dlatego właściwie bardzo ważnym ja chyba zmienię kolorystykę tego, tej ikonki na przyszłość, jest to, jak mocny talend jest w on-premie. No bo wracając do poprzednich moich wypowiedzi, no świat nie wygląda tak różowo, że można tylko chmurowym rozwiązaniem ogarnąć sobie wszystko. Niektóre rzeczy nie mogą ze względu na przykład na compliance wychodzić do chmury, a nadal chcemy coś z tym robić.

Pewne firmy jeszcze nie przeszły ścieżki akceptacji dla chmury ale chcą być na tą chmurę gotowi kiedy ta ścieżka się zakończy sukcesem. Więc talend pozwala na pokrycie Swoim tym sokolem okiem czyli ten administrator w talend Data Fabric czy zespół od Data Operations może koordynować te przetwarzania i on-premise i w chmurze czyli podążać za takim pryncypium, przetwarzać dane tam, gdzie one są albo najbliżej tego, gdzie są.

Druga ważna rzecz to jest też takie działanie, tak też inteligentnie się nazywa push-down, czyli te komponenty które Państwo zobaczą, wywołują te operacje w natywnych technologiach tych źródeł, które mają to zrobić. Jeżeli to jest Hadoop, to na Hadoopie ma produce’owe zabawki sparkowe. Jak to jest Snowflake to procedury zachowane w Snowflake’u, user-defined functions, SQL-e, tego typu rzeczy.

Jak to jest… To mógłbym jeszcze stwierdzić, jakieś BigQuery, to BigQueryowe możliwości wywoływane do wczytywania masowych danych czy wczytywania, nie wiem, streamingu, tego typu rzeczy. Stąd też logotypy, które umieściłem na dole, takie, które chcę, żeby przykuły uwagę. Nieważne jakie to środowisko

dogromadzące dane, analityczna baza danych chmurowa, nie chmurowa, jakieś Hadoop w firmie jakiś SQL Server nadal funkcjonujący sprawnie na dużej maszynie pod biurkiem. To wszystko jest możliwe do zaadresowania talendem, nie narzuca wyboru tej technologii. Jest, jak to się mówi po staropolsku vendor agnostic I teraz krótka pauza, bo pozwólcie Państwo, że spróbuję tutaj wywołać kilka pytań które wyskoczą Państwu na ekranie, bo bardzo jestem ciekaw czy dalej spersonalizować doświadczenie jakie…

W ogóle pytanie, czy widać ankietę? Może ktoś by mi poratował odpowiedzią. Tak. Prosiłbym o tam słowno-muzyczne. Zostawiłem to jako otwarty tekst Będzie szybciej niż lista wszystkich możliwych technologii jakie znam włącznie z tymi, o których się dowiedziałem wczoraj bo ciekaw jestem po pierwsze co jest tym źródłem danych, które Państwo analizują.

Po drugie… Czy już została wybrana jakaś technologia w której najwięcej tej analityki się dzieje? Czy to jest biedny przeciążony MySQL, czy może już któraś z chmurowych technologii, BigQuery, Snowflake, może Microsoft Fabric, może gdzieś jeszcze drzemie Hadoop po jakimś commodity hardware. No i chciałbym też złapać tym trzecim pytaniem Państwa opinie.

Jak opowiedziałem o tych modułach, a jest ich dużo, przyznaję, i w ogóle mam nadzieję, że przez te pół godziny pokażę jak najwięcej z tego, to które z nich budzą największe Państwa zainteresowanie Ja tu widzę live odpowiedzi. Bardzo mnie cieszy że ta jakość danych chyba wychodzi na prowadzenie, przygotowywanie danych, stewardship.

Czyli właściwie nawet te funkcje, które są mniej dla inżynierów To bardzo dobrze. Jeszcze dam chwilę może jeszcze coś dopowiem. Może też mi pomoże to spriorytetyzować prezentację według tego, kto dzisiaj do nas zawitał. Jest Państwa sporo, ale mamy, że tak powiem kworum, które zdecyduje co dalej. To może policzę, pytanie od Pana Marka jest, talend ma chyba też produkt do MDM, a chyba nie ma go na liście.

talend ma w ogóle jeszcze parę innych produktów, które nie są w ogóle treścią dzisiejszego webinaru. Jeszcze zaproszę na nas, dlatego przewrotnie na początku napisałem w pierwszym odcinku, bo jest jeszcze cała duża opowieść o talend Data Catalog, o którym chciałbym zrobić oddzielny webinar. Jest też MDM i z MDM jest tak, że to są możliwości, które można robić tym, co dzisiaj pokażę tylko po prostu jest do tego inaczej skonfigurowane środowisko, żeby było ono ukierunkowane na Master Data Management.

Natomiast funkcjami, które dzisiaj nawet zrobimy też Master Data Management można robić. Można na przykład funkcją Stewardship wyznaczać złoty rekord, jeżeli o tym mówimy, bo też różnie definiują osoby Master Data Management. To czasami jest Data Management, czyli zarządzanie danymi włącznie z semantyką i z tą warstwą metadanych.

To robi talend świetnie, w tym co dzisiaj zobaczymy i w talend Data Catalog, który jest produktem w ogóle Niezależnym ale interwencjącym się jest Data Fabric, czyli korzysta z wiedzy Data Fabric, ale może być też wdrożone zupełnie standalone, wyłącznie do katalogowania danych i tych zadań związanych z opisywaniem środowiska, bez żadnych, jeżeli narzędzia do integracji już są wybrane i to nic nie zmieni.

Dobrze widzę, że to się jakoś konstytuuje nie chcę też przedłużyć i lećmy dalej. Dziękuję za te odpowiedzi jeszcze nie za uczestnictwo czas na demo. Od czego zacznę bo zaraz ekrany będą straszyć i jest na nich sporo szczegółów przyznaję, więc postaram się za bardzo nie majtać myszką, że tak powiem, żeby Państwa uwagi nie zgubić.

Natomiast zacznę od czegoś takiego najlżejszego, najbardziej przyjemnego, odnosząc się do rzadu kolegi z początku, czyli Czy nie mieli Państwo styczności ze Stitchem? Stictch jest takim narzędziem bardzo prostym odpowiednik, jeżeli Państwo na przykład Faith Trana kojarzą, to to jest konkurencja dla Faith Trana.

Stitch jest takim narzędziem SASowym, Talenda, który może dostarczyć takim technologiom, jakie są na liście, zbiory danych z innych technologii, które również są w świecie chmury, SASowych rozwiązań. Teraz pokażę na szybko jakie te integracje są. Mówimy tutaj o systemach SASowych i nie tylko. GitLab Google Analytics, Google 360, HubSpot, są również takie otwarte dziurki jak podpięcie się do dowolnego API.

No i tych konektorów tutaj jest mnóstwo z Lookera na przykład dane można związać z mojego ulubionego MongoDB. W taki sposób przeklikuje się, ten proces chodzi i on będzie z systemu A dostarczał do nas do tego zbioru który jest. Wrócę szybko. Takie destynacje, czyli takie systemy docelowe mogą być uzupełniane danymi z takich zasowych rozwiązań, jakie teraz pokazuję.

Niech ktoś da teraz widać. Dziękuję panu Piotrze. Przewinę to tak na szybko. No najróżniejsze, jakieś deski nie deski Hubspoty, Google Analytics, Lookery, SQL serwery Salesforce’y. Tego typu rzeczy. Kiedy chcemy po prostu przeklikać mamy system A, tak się do niego logujemy i chcemy żeby metodą łapania różnicy docierały wszystkie nowe rzeczy dalej.

I to jest ta najprostsza zabawka ze świata talendu. Drugą rzeczą jaką mamy, to jest coś, i teraz proszę wybaczyć, to wygląda bardzo skomplikowanie, przyznam, mam nadzieję, że widać ten pajączek. To jest środowisko dla programisty integracji danych, również dla programisty MDMA i tak dalej. Są różne inne widoki ale dzisiaj będziemy w takim widoku integracji danych w Data Fabric przez chwilę przebywać.

Z czego ten świat się składa jest w ogóle narzędzie desktopowe. Możliwe do odpalenia na dowolnym sprzęcie, Mac nie Mac, Windows, wirtualna maszyna, cokolwiek który funkcjonuje w Eclipse, jest bazą, w którym mamy po pierwsze, tutaj zmaksymalizuj, żeby też jakoś skoncentrować oglądających mnóstwo konektorów do znanych baz danych, do ulubionego Mongo, Neo4j i tak dalej, jadąc dalej, komponenty służące do na przykład maskowania danych, komponenty służące do czyszczenia danych, zadbania o adresy przejechania adresów Googlem na przykład, standaryzacji maczowania, najróżniejsze metody żeby zadbać Jadąc dalej, bazy danych i takie możliwości dostępu że tak powiem…

Współdzielone, w sensie tutaj nie jest istotne jaka jest technologia, wystarczy żeby był konektor JDBC i do tej bazy się dołączymy. Hadoopy, rzeczy w internecie, coś można zebrać z internetu, coś można zebrać z API typu Open Data itd. I oczywiście klocki służące do obsługi procesów które są tutaj rozrysowane, czyli reakcji na to jaki jest błąd, jakieś równoległe wykonywanie pewnych rzeczy.

No tych komponentów jest mnóstwo nie skłamię jak powiem że kilkaset. Są też odwołania do tych komponentów które są dostępne na platformie Stitcha, czyli z tego co tam jest też można skorzystać. XMLE, JSON-y no mnóstwo rzeczy. To czym chciałem to przybliżyć A nie że tak powiem zniechęcić, to jest wysłanie czegoś w prostym ETL-u do snowflake’a.

W tym drzewie które tutaj jest po lewej ja teraz rozszerzyłem, mamy taką składnicę metadanych, czyli wszystkie bazy z których korzystamy, są rozpisane tutaj po lewej stronie. Ja wziąłem sobie jakąś bazę MySQL, w których jest parę tabel. Wziąłem też snowflake’a, w którym będę wypełniał takie tabele w warstwie stagingu czyli tego pierwszego wyjściowego etapu koncepcji hurtowni danych.

Ten zbiór metadata to jest zbiór opisów formatów danych To może być zbiór opisów API-ów REST-owych, to może być zbiór opisów plików płaskich, to może być opis i konfiguracja Google Analytics, jak Państwo widzą, czy na przykład tutaj z ciekawszych rzeczy azurowe, jakieś rzeczy związane z przechowywaniem danych.

Oczywiście tutaj w tym zarysu nie mam nic zdefiniowanego. I to jest parametryzowane. I to w każdym środowisku w którym to uruchomimy, może być inaczej sparametryzowane. W sensie używać innych sekretów żeby na przykład dostać się do środowiska. Czyli można wytwarzać to, co teraz robię w środowisku z bezpiecznymi danymi małymi, gdzieś na boku.

Deweloper może nie znać danych produkcyjnych, a później jest to wdrażane na produkcję i może chodzić z danymi finalnymi. Tu mam cztery przebiegi takie cztery jobs Te osoby które mam do wykonania. Też nie będę wchodził w szczegóły, ale one są rozrysowane i o takich cechach, głównych cechach opowiem, a mianowicie taki jeden job, jak wcześniej opowiadałem, to jest paczka.

Ta paczka zostanie skompilowana i wysłana do artefaktów które są gromadzone przez talend i później będzie rozpropagowana tam, gdzie ma być wykonana. I ta zabawa polega na tym. Zadanie główne jest tutaj. To jest komponent, który mówi równolegle, czyli wystartuj równolegle cztery strumieni, cztery potoki takie przetwarzania, w których z MySQL-a weźmiemy listę krajów, listę klientów, listę zdarzeń biznesowych, listę produktów i wczytamy do bazy stage na snowflake’u.

A przed tym najpierw zrób taki pre-job. Te pre-joby polegają na tym, że sprawdzamy warunki. Czy mamy dostępną bazę MySQL, czy mamy dostępną bazę w Snowflake’u. Jak tak, to dobrze. Pre-job przekazuje żądanie do dalszego wykonania. Jeżeli nie, to obsługujemy błąd. Tutaj te czerwone strzałeczki to nie jest, że błąd powstał w tym momencie, tylko co zrobić, jak z tym komponentem jest kłopot, zareaguj i poinformuj wykonać coś jeszcze.

Tutaj się może kryć cały szereg akcji jak powtórzyć itd. Jeżeli jest okej idziemy dalej po tej zielonej strzałce. Jeżeli by było coś z tym Snowflake’iem nie halo, też kończymy i mówimy dlaczego skończyliśmy. I post-job, czyli jeżeli to wszystko zostanie wykonane praktycznie Prawidłowo, to Zamknij bazę MySQL-ową, zakończ to połączenie, nie trzymaj otwartego połączenia i zakomituj czyli zapisz już, zamknij transakcję na stagingu tego wszystkiego co wpisywałeś, bo wszystko, co tutaj się działo, może być trzymane w otwartej transakcji, która jak się wywali gdzieś po drodze, nie będzie zakomentowana i może być cofnięta.

Mam takie same zadania związane z podążaniem za, kojarzą koncepcję Slowly Changing Dimensions, tu jest komponent który opanowuje taką sekwencję związaną z wyłapywaniem zmian na artykułach i jeżeli wejdę Konfigurację tego konkretnego dokumentu to on jest tutaj parametryzowany w ten sposób, że porównuje mi tabelę tą pierwotnie wczytywaną do tej która jest moja pierwotna po takim kluczu i jeżeli zauważy w product name lub price zmianę, czyli to SCD typ 2, to odłoży rekord i w tabeli produktów będę miał rekordy historycznych wartości tego produktu i nowych wartości, tak.

Nie zawsze baza źródłowa obsługuje historyzację zmiany wymiarów a bardzo często dla potrzeb analityki, żeby na przykład brać pod uwagę sprzedaż w kategoryzacji, która była przed nowym rokiem i po nowym roku trzeba takie, tego typu rzeczy rozłożyć. Teraz jak taki job mamy tutaj zaplanowany, jego można…

Tak. Może użyję tego jobu stagingowego, mogę go uruchomić i śledzić przebieg działania w postaci logu z działania. Exit code równe 0, ze skutkiem sukcesem się zakończył, też jak sobie rozwiniemy z powrotem to zadanie, pokazałbym tak, jak uruchamiam, to też można śledzić podczas tego etapu deweloperskiego, w jakim tempie te dane przepływają, tych eventów jest 11 sekund przetwarzania, może 14 sekund przetwarzania na moim komputerze jakichś 4 milionów rekordów z SQL-a do Snowflake’a i to się skończyło, o czym wiedziałem z tego okienka innego, ale widzę jaka jest telemetria, zielono, zielono zielono, nic tutaj się złego nie stało.

I teraz wychodząc z tego świata bo mam te cztery zadania i pod prawym przyciskiem jest możliwość wykonania publikacji do chmury lub publikacji. Publikacja daje nam taką paczkę, którą można wykorzystywać w inny sposób niż to, co teraz pokażę, ale najciekawszy scenariusz to jest opublikowanie do chmury.

Czyli taką paczkę mogę opublikować do chmury On mnie ostrzega, że zostawiłem tam domyślne hasła bazy źródłowej. Może bym chciał to usunąć zanim wyślę. Ryzyka nie ma, bo ta baza zaraz nie będzie żywa. No i tu mogę wybrać, do jakiego środowiska ten artefakt ma trafić. I teraz tak, porzucamy to środowisko.

Teraz bym chciał wylądować… Wśród różnych moich okienek muszę znaleźć te właściwe.

To już mi się ukryło. Dobrze. Zaloguj się do chmurowego rozwiązania Talenda. Paluszkiem to potwierdzę. W tymże środowisku mamy najróżniejsze moduły, po których muszę z prędkością odrzutowca przelecieć Tu jest konsola zarządzania. Mówiłem o tym, że te paczki które generujemy lądują jako artefakty na konkretnych środowiskach.

Wrzuciłem te paczki te cztery zadania zaprojektowane przez siebie na środowisko DEV Development. Chwileczkę nie wiem, czy ten pasek jest widoczny, ale nie przeszkadza. Może damy temu trochę więcej przestrzeni, z jakimś 75% i całe okno. Proszę zobaczyć ten staging, który oglądaliśmy, jest taką paczką. Jest rysunek jak ten job przebiega, żeby się ktoś zorientował, co tam w trawie piszczy.

Jest jego parametryzacja. Wśród parametrów są dane, jak się zalogować do tego serwera z którego ciągnąłem dane. I takie zadanie może być… Prowadzone jako zadanie do wykonywania w sposób ciągły, gdzie tutaj charakteryzuje sobie to zadanie jakąś nazwą, podaję te parametry, bo w tym środowisku przecież ta baza może być gdzie indziej i tutaj continue, stworzę zadanie.

Takie zadania mogą być albo wywoływane tutaj z palca albo w naturalniejszy sposób zestaw zadań, może zróbmy jeszcze z dimensions następne zadanie, ja tu jak to się mówi ładnie w języku dewelopera pojadę z defaultów, czyli mamy już dwa zadania w tym środowisku dev, dimensions i staging i ja mogę to zebrać następnie w plan, w tym planie, w tym środowisku w którym chcę uruchomić

Wybiorę że najpierw potrzebuję wczytać dane do stagingu a później wywołać następne. Następne będą dimensions, no i gdybym zrobił jeszcze taski z tych innych zadań, to stworzyłbym to lepiej. I tutaj mam. Tu mam ten plan, tu mam

triggery tak? Czyli w jaki sposób to ma być wykonywane. Chcę co kilka godzin niech ten trigger będzie typu tutaj daily, ale może być też typu cron typu webhook, czyli może być wywoływany z zewnątrz Niech będzie typu daily i ja tutaj lubię taką formę że wyznaczam jakieś konkretne godziny można tych godzin wyznaczać, zapisać I ten plan z tym konkretnym wykonaniem na tych parametrach, które są skonfigurowane w tym środowisku, będzie funkcjonować sobie, jeszcze co ciekawe, na silniku który jest podpięty.

Wśród environments, nie, przepraszam nie wśród environments, tylko w processing widać najróżniejsze silniki. I na przykład taki jeden prosto z pudełka, ale można też następne stawiać może być to na moim laptopie w chmurze w kontenerach i gdybym włączył maszynę, która była postawiona na AWS-ie do tego, sprawowałaby się i byłaby możliwym miejscem wykonywania tych zadań, które przed chwilą projektowałem.

Zamknę tutaj te scenariusze, których inżynier danych Robi integrację bardzo precyzyjną, używając tych zaawansowanych komponentów, definiuje parametry, wrzuca taski. Teraz bym chciał pokazać że w ten proces można włożyć również osoby biznesowe. Data Inventory. To jest taki widok na tą całą platformę w której po pierwsze to jest dashboard, ale do niego wrócę zaraz jak wejdziemy w szczegóły, to później wrócimy w ogóły bo ten dashboard, ten moduł Data Inventory ma pokazywać jakie zbiory danych są w organizacji.

I na przykład Stage Customers to jest ta tabela którą wypełniamy danymi z MySQL-a na środowisku Snowflake. Ona jest… Albo losowo albo z jakiejś próbki, próbkować przez, przez przez talenda i talend ocenia, ocenia tą próbkę pod względem jakości. Przełączę się w ten widok próbki,

zastanawiam się, czy nie, nie wylogowało mnie ze środowiska, zobaczmy może jakąś inną. Jest sobie tabela klientów jest oceniana ze względu na to, co zawiera, jest oceniona pod względem kompletności, validity, popularity itd. Część rzeczy wynika wprost z danych, część rzeczy wynika z tego, jak często jest to używane, czyli czy na przykład ten zbiór ktoś czyta, czy ktoś go procesuje, czy dużo osób go odkrywa, jest popularny, dlatego że o każdym takim zbiorze można trochę również głosować.

Można zobaczyć zbiór kolumnę, każda z kolumn ma taki mini wykresik w którym pokazywana jest jego jakość jakość tych danych. Semantyka, czyli talend odkrywa sam, że to są prawdopodobnie pierwsze imiona Że to jest prawdopodobnie nawet nie odkrył, że to jest nazwisko, tylko że to jest tekst natomiast uważa że te pola oznacza PII, czyli Personal Identifiable Information, czyli dane osobowe.

Ostrzega o tym, że to są dane osobowe i dzięki temu coś z tym można dalej zrobić. Jak się przesunę dalej, na niektórych kolumnach widać też taki czerwony pasek czyli na przykład, zatrzymam się tutaj chwilę ta kolumna pięć cyferek bardzo podobna do słownika kodów pocztowych w Stanach Zjednoczonych, FR, nawet nie wiem co to znaczy, no ale kodów pocztowych w konkretnej lokalizacji.

Natomiast jeżeli ta kolumna jest podobna do tego wzorca semantycznego to… 15,8% ma niewłaściwą wartość nie ma takiej cyfry. No po prostu ktoś na przykład zjadło mu się z głodu jedną z tych cyferek. Tutaj w telefonie coś więcej. Także widać jakość danych szczegółowych, widać też, Ten zbiór się poddał, niech się poddaje, nie ma problemu i na górze widać to w takim ujęciu, w którym cały zbiór jest oceniany, ile ma tych dziur w swojej kompletności.

Z tego są wyliczane miary syntetyczne, tu po prawej jak klikam się po tych wymiarach, widzę też przebieg w czasie, czyli tu widać wyraźnie z tym zbiorem danych, ja właściwie nic nie robiłem, cały czas ma podobną ilość danych, nie czyściłem go, nie robiłem nic więcej, gdybym prowadził kampanię czyszczenia i te miary by się podniosły, byłoby lepiej.

Na całym zbiorze danych można dane certyfikować, czyli ktoś, kto ma uprawnienia może Zdecydować o tym, że dane są wystarczająco dobre, żeby były używane. Można też na temat tych danych głosować. Każdy z użytkowników może dać jakiś głos, który będzie wpływał na te miary powyżej. Przed chwilą obniżyłem, ze względu na taką miękką opinię co z tym można zrobić.

I teraz też w telegraficznym skrócie tu dwa okna. Typy semantyczne, które są w pudełka w dużej ilości, ale można też je zdefiniować i reguły jakości, które parametrycznie można zdefiniować po to, aby zbiory były sprawdzane w ten sposób. Natomiast jeżeli coś chcemy zrobić z tymi danymi są dwa takie moduły.

Data preparation, tak postaram się szybciutko jeden w pięć minut, drugi w pięć minut omówić Data preparation. Zawał polega na tym, że podpinam się do zbioru który jest na tej liście proponowanej Mam nadzieję, że złośliwość rzeczy martwych idę na żywo nie zagra właśnie głównej roli, bo odpisałem tą maszynę AWS-ową, którą Państwo widzieli jako najwyraźniej ten silnik z pudełka utrudni nam tutaj życie.

Zobaczmy data stewardship. Najpierw kliknij, żeby zobaczyć czy mogę o tym mówić. Mogę o tym mówić. Do tego zaraz wrócimy. Dane które zbieramy, można opracowywać na cztery sposoby i tu są przykłady takich czterech technik Arbitration, arbitracja, arbitralnie coś decydujemy, rozwiązujemy problemy łączymy dane, grupujemy dane.

Można określić kampanię takiego czyszczenia danych, czyli wyznacza się definicję, co jest czyszczone, przez kogo, kto będzie to sprawdzał, czy ktoś będzie sprawdzał po tym, który poprawia, jak ta kampania wygląda. Kampania powoduje że jest zbiór zadań. Rekord po rekordzie grupy danych po grupie danych są czyimś zdaniem.

Te zadania mogą być przyporządkowane do konkretnych osób, mogą być też rozdzielone. Ta część dla tych nie wiem, kategorii menedżerów, kupców ta część dla kogoś innego. Na koniec taka osoba wchodzi w swoje zadania które ma tutaj przed oczami i na przykład zadba o katalog produktu Dzięki za uwagę Proszę zobaczyć że tu jest macierz produktów znowu czerwonym kolorem są jakieś dziury w całym, nie wiem, może to jest na przykład katalog produktowy wczytany od klienta i widzę, że ten Tricker Hut

warto sklasyfikować ze względu na materiały. Co mi może w tym pomóc? Tu z prawej strony widać rozkład danych, jakie są możliwe wartości, więc ja bym zdefiniował dla tego Hata poliester i w ten sposób ten przypadek ma swoje nowe dane. Żeby było ciekawiej, to jak tu się przesunąć w prawą stronę będzie widać kto te dane obrabiał.

Ja po przejściu wszystkich tych zadań, bo tu mam ich sporo. Ja po przejściu Bo wszędzie tam, gdzie jest czerwono, muszę coś z tym zrobić. Jeżeli je wszystkie skończę, one znikną mi z listy będą jako lista poprawionych danych ale nie takich, które koniecznie wpadają natychmiast do bazy danych, czyli nie edytuję tego w źródle, tylko jest to jeden z klocków w tym przetwarzaniu, które wcześniej Państwu pokazywałem, w którym może być zadanie które będzie to poprawione dane zwalidowane, bo to też mogą być dwie osoby, jedna poprawia druga waliduje z odpowiednimi uprawnieniami, będzie wczytane do systemu źródłowego.

Albo co ciekawsze i to jest też ten wątek który jeden z Panów podniósł wcześniej, wyzwanie związane z danymi głównymi, tak? Proszę zobaczyć tu jest grupa to jest jak gdyby zadanie drugie. Mam sobie jakiegoś Carla McLeada, dane mam w Salesforce, w Marketo NetSuite i tak dalej, z jakimiś tam wagami te systemy są dla mnie ważne i proszę zobaczyć że chcę zdecydować o tym rekordzie głównym.

Mogę albo szczegół po szczególe zdecydować że wybieram najbardziej używany, bo najczęściej używany tu ciężko jest, bo jest 2 do 2. Ostatnią wiadomość czyli ostatnią wartość czyli w którymś systemie pojawił się ten rekord niedawno więc być może ktoś podał swoją aktualną rolę, albo któryś z wyników najbardziej zaufany.

Mogę rozwiązać że tak powiem, te konflikty na takim rekordzie. Jeżeli ta pierwsza linia ma już komplet… To takie zadanie może zamknąć. I ta dwójka jest na zielono zamknięta, bo to już jest coś, co opracowałem. A na przykład, a już sobie przypomniałem, w tej jedynce problem polegał na tym, że okej dane składają się z Salesforce’a i Marketo, jest to dwa razy podany e-mail, ten sam, ale konsekwentnie błąd poprawia automat, popełnia automat albo ktoś, a jaki?

A no ktoś zapomniał tutaj małpeczki. Więc mogę zdecydować arbitralnie że poprawię to na małpę. Taki będzie mój rekord główny, dwa razy w tą kłódkę i już mam dwie rzeczy zrobione, mogę to 20% wykonanej roboty wysłać do walidacji. Już ktoś następny może pracować i stwierdzić, okej podoba mi się to, jak Manowiecki to poprawił, to przy jutrzejszym wczytywaniu to będą nowe dane główne tego delikwenta w naszych bazach.

Spróbujmy wrócić do data preparation, które się może przeżarło.

Bardzo ciekawe komunikaty, więc nie wiem czy nie poddam tego, co się dzieje. Może spróbujmy niech na pomyśl, na jakimś innym zbiorze na przykład na lokalnym pliku. To jest lokalny plik, bo można też w Data Inventory wrzucić plik, czyli jak gdyby wsadzić w korporacyjny katalog zbiór który jest plikiem płaskim.

Excel, Excel, SVK czy coś. I on ląduje w błogosławionym miejscu Jest tutaj przechowywany i coś dalej ktoś może z nim zrobić. Również oczyścić Tu jest ikonka takiego data preparation, który mogę w tym momencie dodać. I w środku data preparation… Daję mu ostatnią szansę żeby coś zrobił. Wiem na czym błąd mój może polegać.

Wszystkie te funkcje korzystają z tych silników. Jest jeden taki domyślny i on być może w moim ciągłym demo został teraz przeciążony. Powinienem był dorzucić tamtą maszynę jeszcze do pracy z tymi danymi. Proszę zobaczyć jest wczytany ten plik. Znowu dane są ocenione ze względu na jakość. Mogę sobie odfiltrować te dane, które są niewłaściwe.

Mogę też coś zrobić na przykład z danymi osobowymi. Powiedzmy że interesuje mnie, żeby zanonimizować maile. Tutaj mam szereg funkcji najróżniejszych, wśród których jest obfuskacja, mask data, maskowanie danych. Mogę tę kolumnę maila… Zamaskować w losowy lub powtarzalny sposób, czyli jeżeli potrzebny mi jest to jako identyfikator unikalny, ale tylko nie chcę wiedzieć kto to, no to wtedy repeatable, a random to jest takie, które zgubi w ogóle przywiązanie.

Wciskam submit i dodaje mi się to do tej receptury poprawiania danych tu po lewej stronie i proszę zobaczyć ta kolumna skutkuje takimi przypadkami. No mam tylko domeny użytkownika i poszczególne wartości w takiej ilości Nie wiem co jeszcze mógłbym poprawić, ale jest tutaj szereg funkcji i też nie chcę przedłużać.

Znowu to data preparation może służyć w różny sposób, bo ono swoim rezultatem może prowadzić albo do W zależności od tego, do czego jesteśmy uprawnieni. To jest plik płaski, więc tu są dwie możliwości. Gdyby była baza, to by była jeszcze ta trzecia możliwość, czyli poprawiamy istniejący zbiór danych, nadpisujemy to, z czego wczytaliśmy, tworzymy nowy zbiór danych albo modyfikujemy zbiór danych, który był w bazie z tym związany.

No to ja powiedzmy zdefiniuję nowy dataset, nowy webinarowy, local format, może na przykład niech będzie w Excelu next run, użyję tego samego engine’u, który może tym razem da rezultat Wywołałem jako taka osoba nietechniczna jeden z możliwych jobów na tej platformie, on oczywiście jest obserwowalny w konsoli zarządzania i

może za dużo skaczę, bo chciałem pójść do Data Inventory i zobaczyć ten wynikowy zbiór danych. Także Sets, nowy webinarowy jest tutaj, jest w tym momencie też przetwarzany przez silnik i oceniany pod względem jakości danych więc zaraz za jakiś czas… Tak jak inne zbiory danych w kolumnie quality będzie miał swój score, ten syntetyczny talend, trust score i będzie można co do niego również zdecydować, czy jest to mój ulubiony zbiór danych czy jest ktoś kto pobłogosławi, że to jest ten święty plik, z którego można korzystać i tak dalej, i tak dalej.

To środowisko jest oczywiście powiązane z klikiem, ale mała uwaga nie wymaga tego, żeby dalej środowiskiem analitycznym był klik. talend może służyć do zasilania dowolnego BI, dowolnej bazy danych, więc tu się proszę kreatywnością wykazać i swobodą poczuć się nieograniczonym w tym zakresie. Tematów związanych z API może już nie będę dotykał, poza jedną ciekawostką i to będzie koniec demo, który bym z tych zbiorów wybrał, może ten.

To musi być zbiór, który ma bazę danych w tle. I teraz można na takim zbiorze uruchomić API i ten API będzie funkcjonował w wykładni restowej all data, open data, taki bardzo popularny schemat korzystania z danych, można z definicji ściągnąć. I coś takiego również można ustawić jako chodzące na jakimś silniku, ten silnik postawić u siebie on-premise czy posadowić w chmurze i serwować to API dla firm powiązanych czy ekosystemu swoich partnerów w taki techniczny sposób lub wręcz zrobić z tego metodę na to, w jaki sposób BIA je korzystają z danych zgromadzonych w środku.

Tyle jeśli chodzi o demonstrację. Nie będę Państwu udowadniał, że w Snowflake’u te dane wylądowały. Proszę uwierzyć na słowo. Myślę, że teraz czas na sesję pytań i odpowiedzi, przynajmniej przez najbliższe 10 minut i puszczę Państwa wolnych do korzystania z pięknej pogody. Dziękuję. Włączyłem tryb Q&A, w którym można pytanie zadać mogę je wychwytywać i odpowiadać Może to też być pytanie na czacie, jeżeli ktoś z Państwa jest zainteresowany.

U góry wyświetla się przycisk na którym zapraszamy na pokaz narzędzia klikowego zwanego Gold Client, który służy do przerzucania danych testowych między instancjami SAP-a, taka integracja danych ale niezwiązana z analityką. A w najbliższym czasie postaramy się pokazać jeszcze talend Data Catalog, zastosowanie talenda w kontekście Snowflake jako bazy tego typu rzeczy na horyzoncie.

Nie widzę żadnych pytań. Mam nadzieję, że nie zanudziłem, zaciekawiłem. Pozostańmy w kontakcie. Dziękuję Jedno co zrobiłem źle, to na ostatnim moim śladzie nie ma moich danych, ale wiedzą Państwo, gdzie mnie znaleźć. Którykolwiek z kolegów do którego macie e-mail albo mail kontaktowy. Dziękuję Państwu serdecznie w takim razie.

Do usłyszenia przy najbliższej okazji, do zobaczenia na którejś z konferencji, w których uczestniczymy. Życzę w miarę przyjemnego dnia i żeby nie było to jeszcze lato w środku wiosny. Do usłyszenia w następnym razie. Dziękuję.